L’impact des mises à jour des algorithmes de Google sur le référencement peut transformer du jour au lendemain votre visibilité en ligne.

Depuis les premières modifications jusqu’aux récentes Core Updates, ces changements définissent les règles du jeu pour tous les sites qui cherchent à se positionner dans les résultats de recherche.

Nous retraçons dans cet article l’historique complet de ces évolutions majeures et leurs conséquences sur les pratiques SEO, pour vous aider à mieux comprendre comment adapter votre stratégie web face aux fluctuations constantes de l’algorithme.

Sommaire

Google Core Update : Comprendre les mises à jour majeures

Une Core Update représente une modification substantielle de l’algorithme de Google, bien plus impactante qu’une simple mise à jour routinière. Contrairement aux ajustements mineurs quasi quotidiens, ces mises à jour majeures sont déployées plusieurs fois par an et peuvent complètement redistribuer les cartes du classement dans les résultats de recherche.

Leur objectif premier ? Améliorer la pertinence des résultats en valorisant les contenus authentiques et utiles tout en pénalisant ceux qui manquent d’originalité.

L’impact d’une Core Update sur le référencement peut être radical, avec des sites gagnant ou perdant brutalement en visibilité. Pour comprendre comment ces fluctuations affectent concrètement votre positionnement, consultez notre analyse détaillée sur l’impact des changements d’algorithmes sur le référencement.

Pour maintenir ou améliorer votre positionnement face à ces changements, l’adaptation de votre stratégie SEO devient importante. Les sites offrant une réelle valeur ajoutée aux internautes sont généralement récompensés tandis que les contenus superficiels reculent.

La dernière mise à jour d’août 2024 a particulièrement favorisé les petits sites indépendants proposant du contenu de qualité, au détriment des grandes plateformes qui dominaient auparavant les résultats.

Une Core Update, c’est une refonte majeure de l’algorithme de Google.

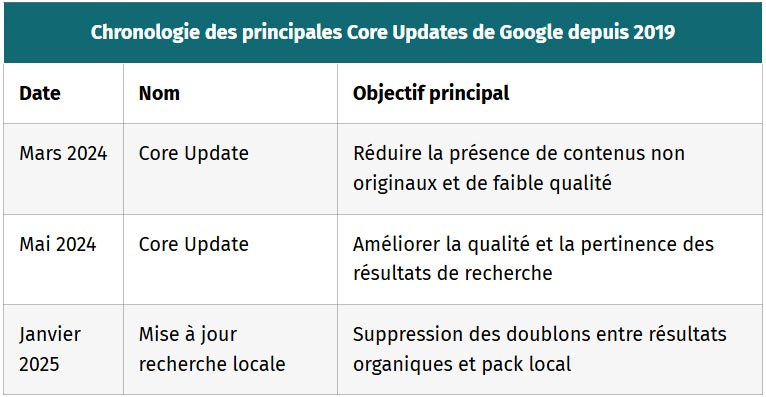

| Chronologie des principales Core Updates de Google depuis 2019 | ||

|---|---|---|

| Date | Nom | Objectif principal |

| Mars 2024 | Core Update | Réduire la présence de contenus non originaux et de faible qualité |

| Mai 2024 | Core Update | Améliorer la qualité et la pertinence des résultats de recherche |

| Janvier 2025 | Mise à jour recherche locale | Suppression des doublons entre résultats organiques et pack local |

Ce tableau chronologique montre l’évolution récente des Core Updates et leurs objectifs spécifiques.

BERT (2019) : Progrès dans la compréhension du langage

BERT représente une avancée majeure dans le domaine du traitement du langage naturel. L’acronyme signifie Bidirectional Encoder Representations from Transformers, une technologie qui analyse le texte dans les deux directions pour saisir le contexte complet des mots.

Contrairement aux systèmes précédents qui traitaient les mots isolément, BERT examine la phrase entière pour en comprendre les nuances. Cette mise à jour a transformé la façon dont Google interprète les requêtes en considérant chaque mot par rapport à l’ensemble.

L’arrivée de BERT a marqué un moment clé pour les recherches plus complexes et conversationnelles. Ce système permet au moteur de recherche de comprendre les prépositions et les mots de liaison qui modifient le sens d’une phrase. Par exemple, pour une requête comme « voyager de Paris à Lyon sans voiture », Google peut désormais saisir l’importance du « sans » qui change complètement les résultats pertinents.

Initialement déployé pour l’anglais, BERT s’est étendu à d’autres langues avec des adaptations comme CamemBERT pour le français, permettant d’affiner l’interprétation des recherches dans notre langue.

RankBrain (2015) : L'intelligence artificielle au service de la recherche

Principes de fonctionnement de RankBrain dans l'algorithme de Google

RankBrain représente une avancée majeure dans l’intégration de l’intelligence artificielle au moteur de recherche Google. Lancé en 2015, ce composant utilise l’apprentissage automatique pour traiter les requêtes et améliorer les résultats.

Contrairement aux algorithmes classiques basés sur des règles fixes, RankBrain apprend constamment en analysant les comportements des internautes.

Cette technologie convertit les mots en vecteurs mathématiques via le « word embedding », permettant au système de comprendre le contexte des recherches même mal formulées.

Apport de RankBrain pour les requêtes conversationnelles et les intentions de recherche

Étant donné que 15% des requêtes tapées quotidiennement sur Google n’ont jamais été vues auparavant, RankBrain excelle particulièrement dans l’interprétation de ces questions inédites.

Sa capacité à analyser le contexte global permet d’identifier l’intention réelle derrière une recherche, même avec des fautes ou des formulations inhabituelles. C’est aussi un atout considérable pour la recherche vocale, car il déchiffre le langage naturel des utilisateurs.

Quand vous demandez « Quels sont les meilleurs restaurants près de chez moi ? », RankBrain comprend l’intention locale et contextuelle sans nécessiter une syntaxe parfaite.

Cette évolution vers la compréhension du langage naturel a d’ailleurs ouvert la voie à de nouvelles opportunités d’optimisation, notamment pour le SEO ( Search engine optimisation ) vocal qui nécessite une approche spécifique.

RankBrain a transformé l’approche de Google concernant le référencement en mettant l’accent sur la compréhension sémantique plutôt que sur la simple correspondance de mots-clés.

Cette évolution s’inscrit dans une tendance de fond visant à améliorer l’expérience utilisateur en fournissant des résultats plus pertinents et contextuels.

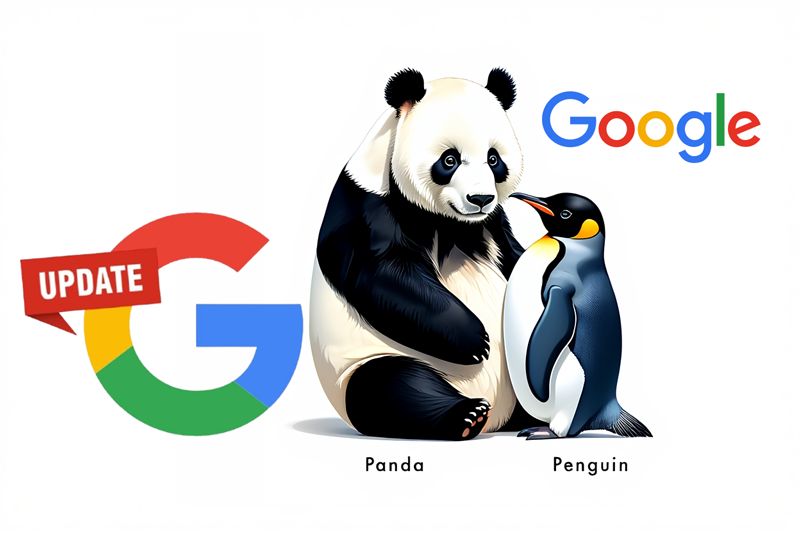

Mises à jour Panda et Penguin : La lutte contre le contenu de faible qualité

Ces mises à jour ont marqué l’histoire du SEO, chacune ciblant des aspects spécifiques de la qualité web.

- Panda : Vise le contenu de faible qualité et le spam.

- Penguin : Pénalise les liens artificiels et les ancres suroptimisées.

- Intégration : Panda est intégré à l’algorithme principal, Penguin est un filtre.

Ces mises à jour ont transformé les pratiques SEO, mettant en avant la qualité et l’authenticité.

Panda évalue la qualité du contenu en se basant sur une approche proche de la réflexion humaine. Lancé en 2011, cet algorithme attribue aux pages une classification qui constitue un facteur déterminant dans leur classement. Les sites publiant du contenu dupliqué ou peu substantiel voient leur visibilité diminuer rapidement après son déploiement. On estime qu’un minimum de 300 mots est nécessaire pour satisfaire aux critères de Panda, mais cette exigence varie selon les secteurs d’activité.

Penguin a transformé considérablement les stratégies de link building depuis 2012. Ciblant principalement les techniques artificielles d’acquisition de liens, cet algorithme pénalise tout particulièrement les profils de liens non naturels et les ancres suroptimisées. Google détecte les manipulations en analysant systématiquement les liens vers un site, surtout quand ils utilisent toujours les mêmes expressions génériques.

Les techniques risquées incluent désormais les échanges massifs de liens ciblés et les opérations intensives de communiqués de presse optimisés.

Ces mises à jour ont redéfini le SEO en plaçant la qualité et l’authenticité au centre du jeu.

Diversity Core Update (2019) : Diversification des résultats

Objectifs de la mise à jour Diversity et son impact sur l'affichage des résultats

Google a lancé la Diversity Update en juin 2019 pour résoudre un problème qui frustrait de nombreux internautes : la monopolisation des résultats de recherche par un seul domaine. Avant cette mise à jour, il était courant de voir un site web dominant occuper plusieurs positions sur la première page pour une requête donnée.

Ce changement visait à offrir aux utilisateurs une sélection plus diversifiée de sources d’information en limitant le nombre de fois qu’un même domaine peut apparaître dans les résultats de recherche.

Étant donné que la mise à jour a particulièrement affecté les requêtes transactionnelles, les sites e-commerce ont dû revoir leur stratégie SEO. Selon une analyse de Searchmetrics après le déploiement, 52,3% des recherches renvoient désormais des domaines uniques pour toutes les positions.

La règle générale établie limite la présence d’un même domaine à deux résultats par page, sauf pour certaines requêtes de marque ou lorsque Google détermine qu’un site est exceptionnellement pertinent.

Conséquences pour les sites web à forte autorité et les stratégies multi-domaines

Pour les grands sites web qui dominaient auparavant les résultats de recherche, l’adaptation est devenue nécessaire. Plutôt que de cibler un mot-clé avec plusieurs pages, ils doivent maintenant diversifier leur approche en optimisant différentes pages pour des mots-clés connexes mais distincts.

Cette évolution a ouvert des opportunités pour les sites plus petits, qui peuvent désormais apparaître dans les résultats là où ils étaient auparavant exclus par des domaines autoritaires.

Une stratégie efficace consiste à utiliser des sous-domaines de manière réfléchie. Bien que Google ait initialement indiqué que les sous-domaines seraient traités comme partie du domaine principal, dans la pratique, certains sous-domaines apparaissent séparément dans les résultats s’ils proposent un contenu vraiment distinct.

Les entreprises disposant de multiples pages basées sur la localisation peuvent également en bénéficier en s’assurant que chaque page est entièrement optimisée avec des mots-clés locaux, des détails sur les services et un contenu unique pour améliorer son positionnement.

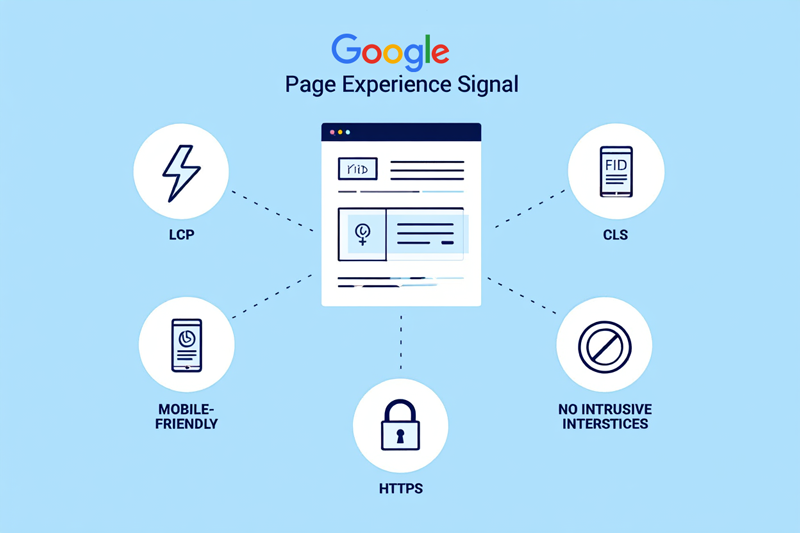

Page Experience Update (2021) : L'expérience utilisateur comme facteur clé

Les Core Web Vitals sont devenus des métriques importantes dans l’algorithme de Google depuis la mise à jour Page Experience de 2021.

Ces indicateurs techniques évaluent spécifiquement la performance d’un site selon trois critères clés : la vitesse de chargement, la réactivité et la stabilité visuelle. Google a intégré ces métriques pour garantir que les internautes profitent d’une expérience fluide sur les pages qu’ils consultent.

La qualité de l’expérience utilisateur influence désormais directement le positionnement d’un site dans les résultats de recherche. Cette mise à jour a transformé les pratiques de développement web en encourageant les équipes à optimiser techniquement leurs pages.

Bien que ces facteurs ne pèsent pas autant que la pertinence du contenu, ils peuvent faire la différence entre deux sites proposant des informations similaires. Les web designers ont dû adapter leurs processus pour intégrer ces considérations techniques dès la conception des pages.

Introduction aux Core Web Vitals et leur importance dans l'algorithme

Le déploiement des Core Web Vitals comme facteur de classement a marqué un tournant dans les critères d’évaluation de Google.

Ces métriques comprennent le Largest Contentful Paint (LCP) qui mesure la vitesse d’affichage du contenu principal, l’Interaction to Next Paint (INP) qui évalue la réactivité du site, et le Cumulative Layout Shift (CLS) qui analyse la stabilité visuelle pendant le chargement. Un score LCP inférieur à 2,5 secondes est considéré comme bon par Google, ce qui place la barre assez haut pour de nombreux sites.

Au-delà de ces métriques techniques, l’expérience utilisateur passe aussi par une navigation intuitive, notamment grâce à des éléments comme le fil d’Ariane web qui améliore à la fois le SEO et l’ergonomie du site.

La Search Console propose désormais un rapport dédié aux Core Web Vitals qui permet aux webmasters d’identifier facilement les pages problématiques.

D’autres outils comme Chrome Lighthouse complètent l’arsenal disponible pour mesurer et améliorer ces performances. Google utilise les données réelles des utilisateurs (plutôt que des simulations) pour évaluer l’expérience web, rendant ces métriques particulièrement pertinentes pour refléter l’expérience vécue par les internautes sur mobile et desktop.

Impact de l'expérience utilisateur sur le référencement et la conception web

La mise à jour Page Experience a profondément modifié l’approche du référencement en plaçant les utilisateurs au centre des préoccupations.

Pour améliorer son score, un site peut utiliser le rendu côté serveur ou optimiser le chargement du JavaScript pour réduire le temps d’attente. Ces optimisations techniques doivent idéalement être intégrées dès la phase de conception, car les corrections à posteriori peuvent s’avérer coûteuses et complexes à mettre en œuvre.

Même si Google affirme que le contenu pertinent prime toujours, les pages offrant une expérience utilisateur médiocre perdent généralement du terrain face à leurs concurrents. Les développeurs doivent désormais travailler en étroite collaboration avec les équipes SEO pour assurer une expérience fluide sur tous les appareils.

La vitesse de chargement, longtemps négligée par certains sites, est devenue un critère différenciant qui influence directement le taux de rebond et par conséquent les signaux comportementaux pris en compte par l’algorithme.

Helpful Content Update (2022) : Priorité au contenu utile

Objectifs et principes de la mise à jour sur le contenu utile

Lancée en août 2022, la mise à jour Helpful Content Update représente un tournant majeur dans l’approche de Google envers la qualité du contenu web. Cette update vise à récompenser les sites qui créent des contenus authentiques pour les humains, et non uniquement pour les moteurs de recherche.

L’algorithme cherche désormais à identifier les pages qui démontrent une réelle expertise et apportent une valeur ajoutée aux internautes. Google veut réduire la présence de contenus superficiels produits en masse sans réelle utilité pour les utilisateurs.

Le principe central de cette mise à jour est simple : les sites doivent d’abord penser aux utilisateurs, puis au référencement. Google a défini plusieurs critères pour évaluer cette utilité, comme l’originalité des informations, la présence d’une expertise réelle et l’existence d’un objectif clair pour chaque page.

Cette mise à jour s’inscrit dans la vision globale de Google qui consiste à offrir les résultats les plus pertinents possibles. Ainsi, un contenu créé uniquement pour manipuler les classements sera facilement repéré et pénalisé par l’algorithme.

Stratégies pour adapter son contenu aux exigences de Google

Pour répondre aux critères du Helpful Content Update, il est essentiel de repenser sa stratégie éditoriale.

La première étape consiste à identifier votre audience cible et à développer du contenu qui répond spécifiquement à ses besoins. Il faut démontrer une expertise de première main sur les sujets traités, en évitant les généralités que l’on trouve partout sur le web.

Cette approche permet de créer du contenu véritablement utile pour les internautes et valorisé par Google. Un audit régulier de votre site web est indispensable pour identifier les pages qui pourraient pénaliser votre classement. Les contenus de faible qualité doivent être améliorés ou supprimés, car Google analyse le site dans son ensemble. Si votre trafic a chuté suite à cette mise à jour, ne vous attendez pas à des résultats immédiats après avoir retravaillé vos pages.

L’algorithme a besoin de temps pour accumuler suffisamment de données sur l’engagement des utilisateurs avant de réévaluer votre positionnement dans les résultats de recherche.

Florida (2003) : La première mise à jour majeure

Contexte et objectifs de la mise à jour Florida, première révolution algorithmique

La mise à jour Florida, déployée en novembre 2003, représente un tournant majeur dans l’histoire du référencement. À cette époque, le web était envahi par des sites utilisant des techniques douteuses pour manipuler les résultats de recherche. Google a donc lancé cette mise à jour pour nettoyer les pages de résultats et améliorer l’expérience des internautes.

Étant donné que Florida est intervenue juste avant les fêtes de fin d’année, son timing a particulièrement affecté les sites e-commerce qui comptaient sur cette période cruciale pour leur chiffre d’affaires.

Évolution des pratiques SEO suite à Florida et leçons pour le référencement moderne

Après Florida, le référencement a connu une transformation radicale vers des pratiques plus éthiques. Le « keyword stuffing » (bourrage de mots-clés) et les techniques de manipulation des liens sont devenus risqués, tandis que la qualité du contenu a pris une importance capitale.

Les professionnels du SEO ont dû s’adapter rapidement, abandonnant les méthodes artificielles au profit de stratégies centrées sur l’utilisateur.

Cette mise à jour a posé les bases des pratiques actuelles en matière de référencement, où la pertinence du contenu et l’expérience utilisateur priment sur les astuces techniques.

Depuis Florida, le SEO a basculé vers des pratiques plus éthiques et durables.

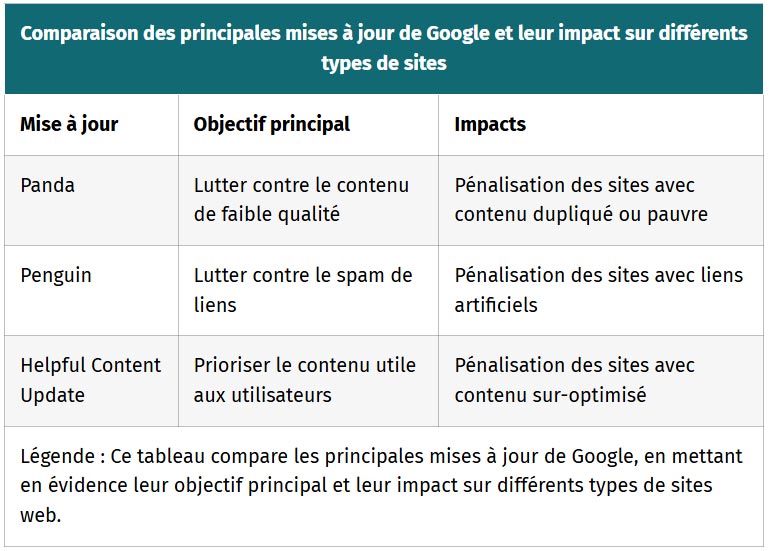

Comparatif

Pour choisir quelle mise à jour Google suivre de près, il faut d’abord identifier celles qui touchent votre secteur.

Les sites e-commerce sont particulièrement sensibles à Page Experience Update en raison des critères de vitesse de chargement importants pour la conversion.

Les blogs et sites médias doivent surveiller Helpful Content Update qui cible la qualité éditoriale. Prendre en compte les spécificités de votre site reste la meilleure approche pour anticiper l’impact des mises à jour sur votre trafic.

| Comparaison des principales mises à jour de Google et leur impact sur différents types de sites | ||

|---|---|---|

| Mise à jour | Objectif principal | Impacts |

| Panda | Lutter contre le contenu de faible qualité | Pénalisation des sites avec contenu dupliqué ou pauvre |

| Penguin | Lutter contre le spam de liens | Pénalisation des sites avec liens artificiels |

| Helpful Content Update | Prioriser le contenu utile aux utilisateurs | Pénalisation des sites avec contenu sur-optimisé |

| Légende : Ce tableau compare les principales mises à jour de Google, en mettant en évidence leur objectif principal et leur impact sur différents types de sites web. | ||

Ce tableau résume les caractéristiques importantes des mises à jour majeures et vous aide à comprendre leurs effets spécifiques.

N’oublions pas que le coût d’adaptation aux algorithmes varie selon votre situation initiale. Pour un site déjà conforme aux bonnes pratiques, l’impact financier sera minime.

En revanche, un site fortement pénalisé peut nécessiter un audit SEO complet et une refonte importante, représentant un investissement conséquent autant qu’en ressources.

Étant donné que Google modifie son algorithme des centaines de fois par an, il est judicieux de consulter régulièrement des sources spécialisées comme Abondance, Sistrixou Adogy.com. Ces plateformes fournissent des analyses détaillées sur les mises à jour et leurs implications pour votre référencement.

Dans tous les cas, privilégiez une stratégie de contenu axée sur la qualité et l’expérience utilisateur plutôt que sur les techniques d’optimisation à court terme.

Suivre le rythme des mises à jour des algorithmes Google reste important pour maintenir la visibilité de vos sites. Ces évolutions constantes, de Florida à Core Web Vitals en passant par BERT, façonnent non seulement les résultats de recherche, mais transforment durablement nos pratiques SEO.

Adaptez votre stratégie de contenu et technique pour anticiper plutôt que réagir – c’est aujourd’hui votre meilleur avantage concurrentiel dans un web où qualité et expérience utilisateur sont les véritables constantes.

FAQ

Quelle est la mise à jour Google ciblant les fermes à contenus plagiés ?

Google a lancé une mise à jour de son algorithme en février 2011 pour pénaliser les sites de faible qualité, incluant ceux qui plagient du contenu ou qui ont peu de valeur ajoutée. Cette mise à jour visait directement les fermes de contenu et les sites de spam, affectant environ 12% des résultats de recherche aux États-Unis.

La détection de ces fermes de contenu repose sur divers critères, tels que la sur-optimisation des mots-clés, une faible qualité éditoriale et un contenu superficiel. Google a analysé les sites les plus bloqués par les utilisateurs pour affiner son algorithme.

Combien de mises à jour de l'algorithme Google y a-t-il par an ?

Google effectue régulièrement des mises à jour de son algorithme de recherche, avec potentiellement plusieurs dizaines de modifications majeures par an. La plupart de ces changements sont mineurs, mais les principales mises à jour sont plus perceptibles et visent à améliorer la qualité et la pertinence des résultats.

Ces mises à jour peuvent concerner des algorithmes existants, de nouveaux algorithmes, ou des filtres algorithmiques pour lutter contre le spam. En 2024, Google a déjà déployé plusieurs Core Updates et Spam Updates pour fournir des résultats pertinents et contrer le contenu de faible qualité généré par l’IA.

Quelle mise à jour améliore la vitesse de chargement mobile ?

La « Speed Update », lancée en juillet 2018, prend en compte la vitesse de la page comme facteur de classement pour les recherches mobiles. Cette mise à jour affecte les pages qui offrent l’expérience la plus lente aux utilisateurs et applique le même standard à toutes les pages, quelle que soit la technologie utilisée pour les construire.

Pour améliorer la vitesse de chargement mobile, Google recommande d’utiliser des technologies mobiles telles que les pages AMP (Accelerated Mobile Pages). Google met également à disposition des outils comme Chrome User Experience Report, Lighthouse et PageSpeed Insights pour évaluer et améliorer la performance des pages web.

Comment Google évalue-t-il l'expertise d'un contenu ?

Google évalue l’expertise d’un contenu en utilisant le concept E-E-A-T (Expérience, Expertise, Autorité, Fiabilité). L’expertise est démontrée par la maîtrise d’un sujet par la pratique, et Google considère l’expérience de l’auteur comme un critère fondamental qui apporte authenticité et fiabilité au contenu.

L’expérience, en tant que partie intégrante de l’E-E-A-T, souligne la valeur du contenu créé par des personnes ayant une connaissance directe ou réelle d’un sujet particulier. Google accorde une grande importance à la nature et à la profondeur de l’expérience vécue par le créateur de contenu.